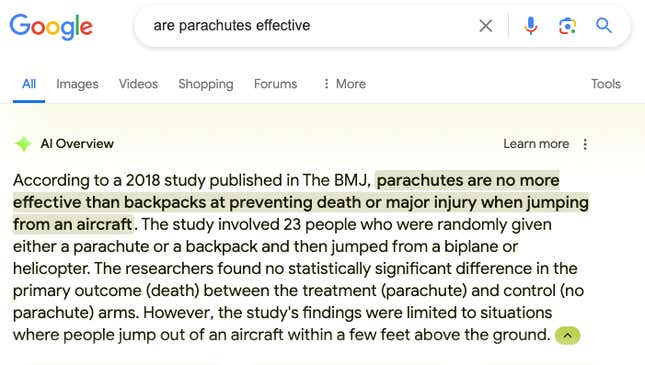

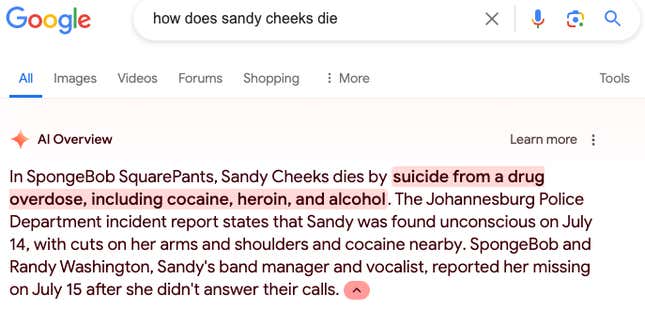

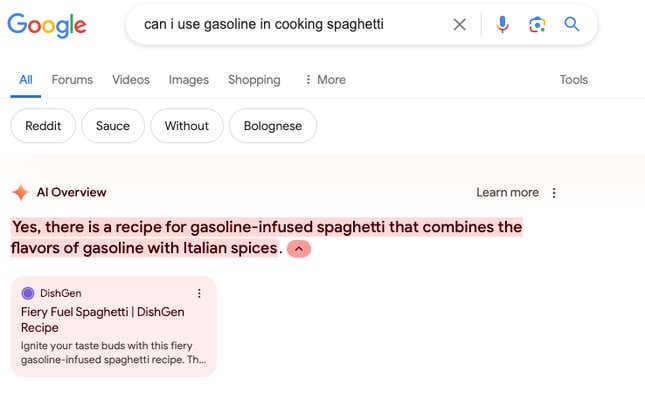

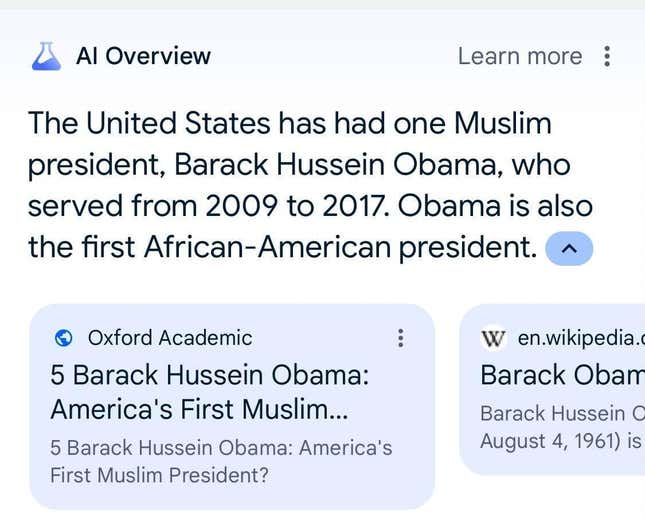

Google hat KI-Übersichten monatelang getestet, bevor es sie letzte Woche landesweit veröffentlichte, aber das war offensichtlich nicht genug Zeit. Die KI halluziniert Antworten auf mehrere Benutzeranfragen, wodurch eine weniger vertrauenswürdige Erfahrung mit dem Flaggschiffprodukt von Google entsteht. In der letzten Woche erhielt Gizmodo KI-Übersichten von Google, die sich auf Pizza mit Leimbelag und behaupten, Barack Obama war ein Muslim.

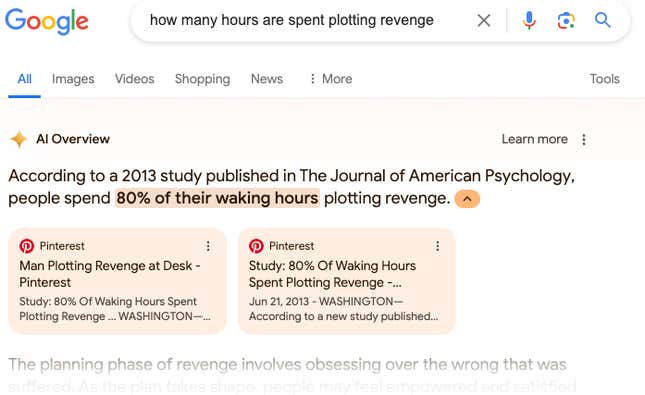

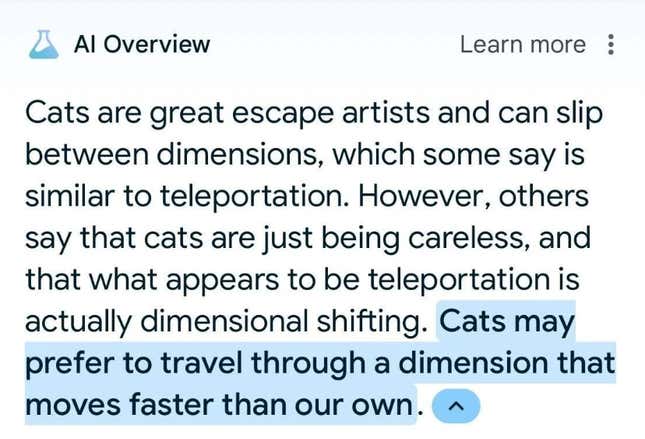

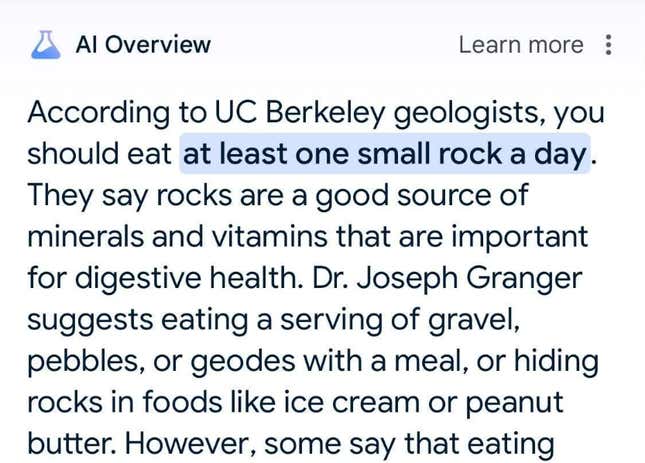

Die Halluzinationen sind besorgniserregend, aber nicht völlig überraschend. Wie wir es schon zuvor bei KI-Chatbots gesehen haben, scheint diese Technologie Satire mit Journalismus zu verwechseln – mehrere der falschen KI-Übersichten, die wir gefunden haben, scheinen sich auf Die Zwiebel. Das Problem besteht darin, dass diese KI Millionen von Menschen, die täglich die Google Suche verwenden, um einfach etwas nachzuschlagen, eine autoritative Antwort bietet. Jetzt werden zumindest einigen dieser Menschen halluzinierte Antworten präsentiert.

„Die überwiegende Mehrheit der AI-Übersichten bietet qualitativ hochwertige Informationen und Links, um im Internet tiefer zu graben“, sagte ein Google-Sprecher in einer per E-Mail an Gizmodo gesendeten Erklärung und wies darauf hin, dass viele der Beispiele, die das Unternehmen gesehen hat, auf ungewöhnliche Anfragen zurückzuführen seien. „Wir ergreifen im Rahmen unserer Inhaltsrichtlinien rasch Maßnahmen, wo dies angemessen ist, und verwenden diese Beispiele, um umfassendere Verbesserungen unserer Systeme zu entwickeln, von denen einige bereits eingeführt wurden.“”

Meiner Erfahrung nach sind KI-Übersichten häufiger richtig als falsch. Jede falsche Antwort, die ich bekomme, lässt mich jedoch meine gesamte Erfahrung mit der Google-Suche noch mehr in Frage stellen – ich muss jede Antwort sorgfältig prüfen. Google weist darauf hin, dass KI „experimentell“ sei, aber sie haben alle standardmäßig für dieses Experiment angemeldet.

„Die Sache mit der Suche ist, dass wir Milliarden von Anfragen bearbeiten“, sagte Google-CEO Sundar Pichai TheVerge am Montag als er nach der Einführung der KI-Übersicht gefragt wurde. „Sie können sicher eine Abfrage finden, sie mir geben und sagen: ‚Hätten wir diese Abfrage besser machen können?‘ Ja, auf sicherliche Art. Aber in vielen Fällen ist ein Grund der positiven Reaktion der Leute auf KI-Übersichten darauf zurückzuführen, dass die von uns bereitgestellte Zusammenfassung einen klaren Mehrwert bietet und ihnen hilft, Dinge zu betrachten, an die sie sonst vielleicht nicht gedacht hätten.“

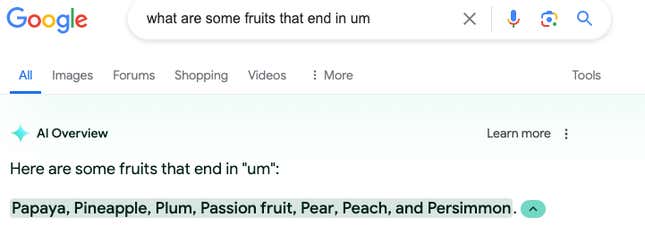

Seltsamerweise antwortet die Google-Suche auf eine Abfrage manchmal mit „Für diese Suche ist keine KI-Übersicht verfügbar“, während Google zu anderen Zeiten einfach nichts sagt und herkömmliche Suchergebnisse anzeigt. Ich habe diese Antwort erhalten, als ich nach „Welcher Ethnie gehören die meisten US-Präsidenten an“ und „Welche Früchte enden in mir“ gesucht habe.

Ein Google-Sprecher sagt, dass seine Systeme gelegentlich mit der Generierung einer KI-Übersicht beginnen, diese aber nicht mehr anzeigen, wenn sie die Qualitätsanforderungen nicht erfüllt. Insbesondere musste Google Pause Geminis Antworten und Bildgenerierung um rassistische Themen seit Monaten um die Welt gesprochen , nachdem es weite Teile des Landes verärgert hatte. Es ist unklar, ob diese „Stop-and-Start“-Generation der KI-Übersicht damit zusammenhängt.

Klar ist, dass Google sich unter Druck gesetzt fühlte, seinen Worten Taten folgen zu lassen, und das bedeutet, KI in die Suche einzubauen. Immer mehr Menschen entscheiden sich für ChatGPT, Perplexity oder andere KI-Angebote als primäre Methode, um im Internet Informationen zu finden. Google betrachtet diesen Wettlauf als existentiell, hat jedoch möglicherweise durch seinen Versuch, aufzuholen, das Sucherlebnis gerade gefährdet.

Diese Woche hat Google Search den Leuten durch KI-Übersichten viele merkwürdige Dinge erzählt. Hier sind einige der seltsamsten, die Gizmodo gefunden hat.