Ein Richter im Bundesstaat Washington hat die Vorlage von Videobeweisen, die durch KI verbessert wurden, in einem Dreifachmordprozess blockiert. Und das ist ein Das ist gut so, wenn man bedenkt, dass viel zu viele Leute darüber nachdenken, eine … anzuwenden KI-Filter kann ihnen Zugang zu geheimen visuellen Daten gewähren.

Richter Leroy McCullough im King County, Washington, schrieb in einem neuen Urteil, dass die KI-Technologie „undurchsichtige Methoden verwendet, um darzustellen, was das KI-Modell ist.“ „Denkt“ sollte angezeigt werden“, heißt es in einem neuen Bericht von NBC-Nachrichten Dienstag. Und das ist ein erfrischendes Stück Klarheit darüber was mit diesen KI-Tools in einer Welt des KI-Hypes passiert.

„Dieses Gericht stellt fest, dass die Zulassung dieser durch Al verstärkten Beweise zu einer Verwirrung der Sachverhalte und zu einer Verwirrung der Augenzeugenaussagen führen würde. „und könnte zu einem zeitaufwändigen Prozess innerhalb eines Prozesses über den vom KI-Modell verwendeten, nicht peer-reviewbaren Prozess führen“, sagte McCullough schrieb.

In dem Fall geht es um Joshua Puloka, einen 46-Jährigen, der beschuldigt wird, in einer Bar außerhalb von Seattle drei Menschen getötet und zwei weitere verletzt zu haben. im Jahr 2021Die Anwälte von Puloka wollten KI-gestützte Mobiltelefonvideos einführen, die von Unbeteiligten aufgenommen wurden. Es ist jedoch nicht klar, was ihrer Meinung nach dazu führen könnte aus dem veränderten Filmmaterial entnommen werden.

Die Anwälte von Puloka haben Berichten zufolge einen „Experten“ für die kreative Videoproduktion eingesetzt, der noch nie zuvor an einem Strafverfahren gearbeitet hatte, um das Video zu „verbessern“. Das von diesem namenlosen Experten verwendete KI-Tool wurde von einem in Texas ansässigen Unternehmen entwickelt Topaz Labs, das für jeden mit Internetanschluss verfügbar ist.

Die Einführung von KI-gestützten Bildgebungstools hat in den letzten Jahren zu weit verbreiteten Missverständnissen darüber geführt, was mit dieser Technologie möglich ist. Viele Menschen glauben das Das Ausführen eines Fotos oder Videos durch KI-Upscaler kann Ihnen eine bessere Vorstellung von den bereits vorhandenen visuellen Informationen vermitteln. Aber in der Realität , liefert die KI-Software kein klareres Bild der im Bild vorhandenen Informationen – die Software ist es einfach hinzufügen Informationen, die überhaupt nicht vorhanden waren.

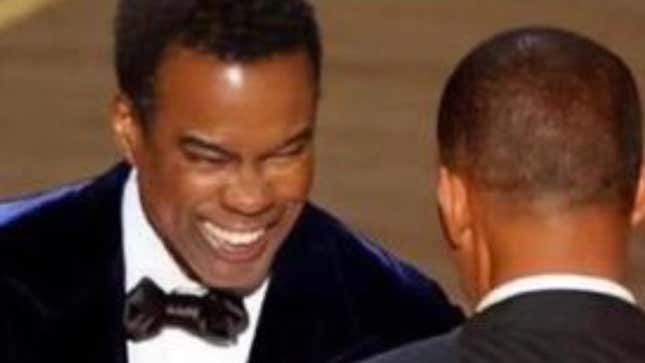

Beispielsweise gab es eine weitverbreitete Verschwörungstheorie, dass Chris Rock eine Art Gesichtspolster trug, als er von Will Smith geschlagen wurde bei den Academy-Awards im 2022. Die Theorie entstand, weil die Leute anfingen, Screenshots des Slap durch Image-Upscaler laufen zu lassen, in der Überzeugung, dass sie das bekommen könnten einen besseren Anblick Was passierte.

Aber das passiert nicht, wenn Sie Bilder mithilfe der KI-Verbesserung ausführen. Das Computerprogramm fügt lediglich weitere Informationen hinzu, um etwas zu erstellen Das Bild wird schärfer, was oft zu einer Verzerrung dessen führen kann, was tatsächlich vorhanden ist. Mit dem Schieberegler unten können Sie das verpixelte Bild sehen, das viral ging bevor Menschen anfingen, es durch KI-Programme zu füttern, und Dinge „entdeckten“, die in der Originalsendung einfach nicht enthalten waren.

Unzählige hochauflösende Fotos und Videos vom Vorfall zeigen schlüssig, dass Rock kein Pad im Gesicht hatte. Aber das war nicht der Fall Verhindern Sie, dass Menschen glauben, sie könnten etwas sehen, das deutlich sichtbar ist, indem Sie das Bild auf „8K“ „hochskalieren“.

Der Aufstieg von Produkten, die als KI gekennzeichnet sind, hat beim Durchschnittsmenschen für große Verwirrung darüber gesorgt, was diese Tools wirklich leisten können. Groß Sprachmodelle wie ChatGPT überzeugt, dass diese Chatbots zu komplexen Schlussfolgerungen fähig sind, wenn das unter der Haube einfach nicht etwas passiert.LLMs sind Im Grunde geht es nur darum, das nächste Wort vorherzusagen, das es ausspucken sollte, um wie ein plausibler Mensch zu klingen. Aber weil sie es ziemlich gut machen Obwohl sie wie Menschen klingen, glauben viele Benutzer, dass sie etwas Ausgeklügelteres als nur einen Zaubertrick ausführen.

Und das scheint die Realität zu sein, mit der wir so lange leben werden Milliarden von Dollar werden in KI-Unternehmen gesteckt.Viele Menschen, die es besser wissen sollten, glauben, dass sich hinter dem Vorhang etwas tiefgreifendes abspielt, und sind schnell bereit, „Voreingenommenheit“ und Leitplanken dafür verantwortlich zu machen zu streng sein. Aber wenn Sie etwas tiefer graben, werden Sie diese entdecken sogenannte Halluzinationen sind nicht irgendeine geheimnisvolle Kraft, die von Menschen ausgeübt wird, die zu wach sind, oder was auch immer. Sie sind einfach ein Produkt dieser KI-Technologie nicht seinen Job sehr gut machen

Glücklicherweise hat ein Richter in Washington erkannt, dass diese Technologie kein besseres Bild liefern kann. Allerdings zweifeln wir nicht daran, dass es in den USA viele Richter gibt, die auf den KI-Hype aufgesprungen sind und die Auswirkungen nicht verstehen. Es ist nur eine Frage der Zeit, bis wir ein KI-gestütztes Video vor Gericht bekommen, das nichts weiter zeigt als visuelle Informationen, die lange nachträglich hinzugefügt wurden.

Eine Version dieses Artikels erschien ursprünglich auf Gizmodo.

Dieser Inhalt wurde maschinell aus dem Originalmaterial übersetzt. Aufgrund der Nuancen der automatisierten Übersetzung können geringfügige Unterschiede bestehen. Für die Originalversion klicken Sie hier