Nvidia ist der Taylor Swift unter Technologieunternehmen.

Es ist KI-Kunden berappen 40.000 Dollar für fortschrittliche Chips und warten manchmal Monate auf die Technologie des Unternehmens und bleiben dem Unternehmen treu selbst wenn konkurrierende Alternativen auf den Markt kommen. Diese Hingabe kommt davon , dass Nvidia der größte KI-Chiphersteller Spiel in der Stadt. Aber es gibt auch wichtige technische Gründe, die die Benutzer immer immer wieder kommen lassen.

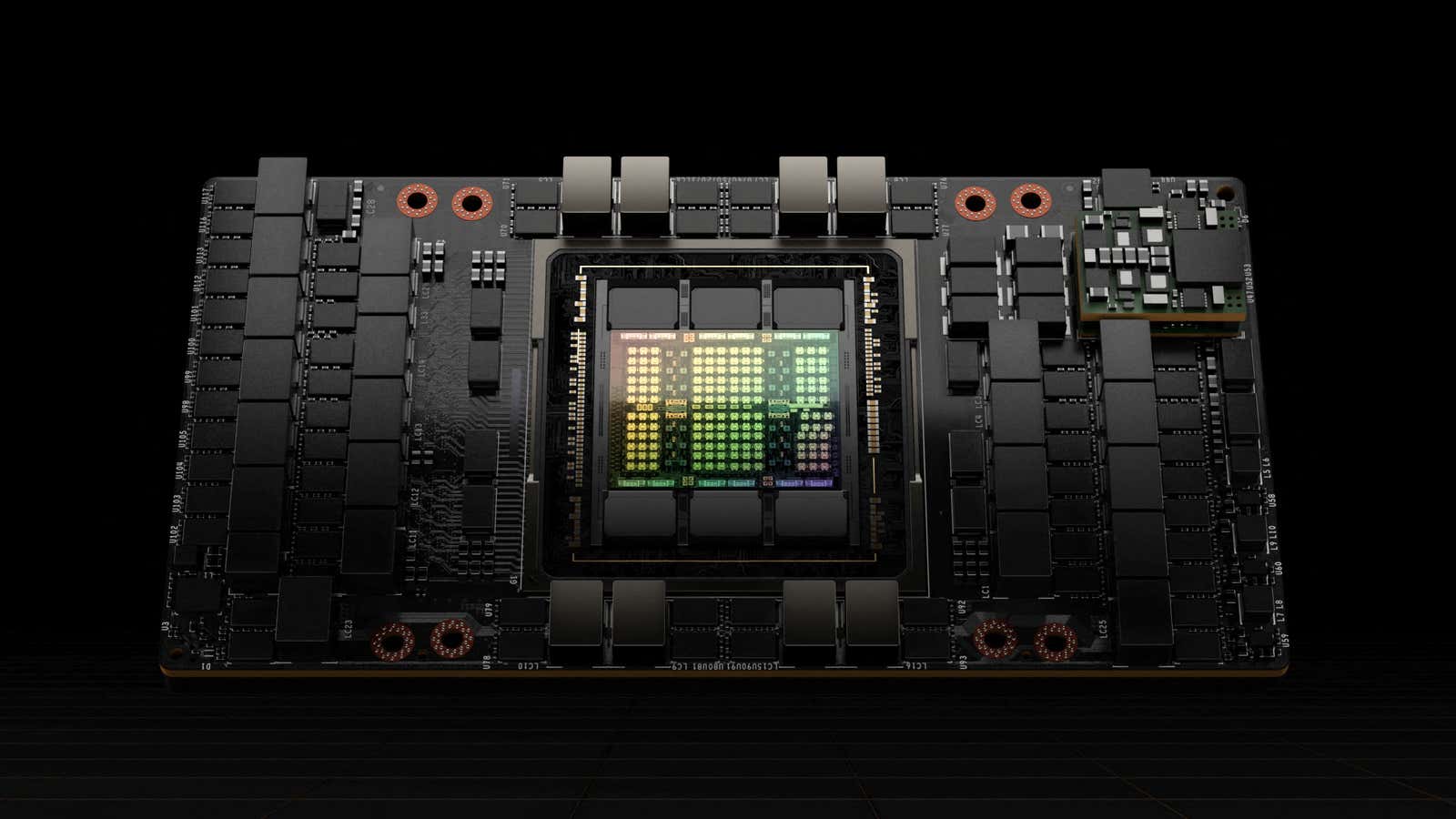

Beispielsweise ist es nicht einfach, einen Chip gegen einen anderen auszutauschen – Unternehmen bauen ihre KI-Produkte nach den Spezifikationen dieser Chips. Der Wechsel zu einer anderen Option könnte bedeuten, dass man zurückgehen und KI-Modelle neu konfigurieren muss, was ein zeitaufwändiges und teures Unterfangen ist. Es ist auch nicht einfach. y um verschiedene Chiptypen zu mischen und anzupassen. Und es ist nicht nur die Hardware: CUDA, Nvidias Software zur Steuerung von KI-Chips sogenannten GPUs, funktioniert wirklich gut, sagt Ray Wang, CEO von Constellation Research mit Silicon Valley. Wang sagt das hilft dabei Nvidias Marktdominanz zu stärken.

„Es ist nicht so, dass es eine Bindung gibt“, sagte er. „Es ist nur so, dass sich niemand wirklich die Zeit genommen hat, zu sagen: ‚Hey, lasst uns etwas Besseres bauen.‘“

Das könnte sich ändern. In den letzten zwei Wochen Technologieunternehmen haben begonnen, Nvidia zum Mittagessen zu überreden, mit Facebook-Elternteil Meta, Google übergeordnetes Alphabet, und AMD alle enthüllen neue oder aktualisierte Chips. Andere darunter Microsoft und Amazonas haben auch kürzlich Ankündigungen zu eigenen Chipprodukten gemacht.

Während Es ist unwahrscheinlich, dass Nvidia in absehbarer Zeit vom Thron verdrängt wirdDiese und andere Bemühungen könnten die Position des Unternehmens gefährden. geschätzter 80% Marktanteil indem sie einige der Schwächen des Chipherstellers ausnutzen, ein sich veränderndes Ökosystem zu nutzen – oder beide.

Verschiedene Chips eignen sich besser für unterschiedliche KI-Aufgaben, doch der Wechsel zwischen verschiedenen Optionen bereitet Entwicklern Kopfschmerzen. Es kann sogar bei unterschiedlichen Modellen desselben Chips schwierig sein, sagt Wang. Die Entwicklung einer Software, die mit verschiedenen Chips gut zusammenarbeiten kann, schafft neue Möglichkeiten für die Konkurrenz, so Wang. Verweisen auf eine API als Startup das bereits an einem solchen Produkt arbeitet.

„Die Leute werden herausfinden, dass sie manchmal CPUs, manchmal GPUs und manchmal TPUs brauchen, und sie werden Systeme bekommen, die sie tatsächlich durch alle drei führen“, sagte Wang – und bezog sich dabei auf Zentralprozessoren, Grafikprozessoren und Tensorprozessoren, also drei verschiedene Arten von KI-Chips.

Im Jahr 2011 hat der Risikokapitalgeber Marc Andreessen verkündete einst, dass Software die Welt auffrisst. Das gilt auch im Jahr 2024 noch für KI-Chips, die zunehmend von Software-Innovationen getrieben werden. Der KI-Chip-Markt erlebt einen bekannten Wandel mit Ähnlichkeiten aus der Telekommunikation, wo Geschäftskunden von mehreren Hardwarekomponenten zu integrierten Softwarelösungen übergegangen sind, sagt Jonathan Rosenfeld, Leiter der FundamentalAI-Gruppe am MIT FutureTech.

„Wenn man sich die tatsächlichen Fortschritte bei der Hardware ansieht, stammen diese nicht einmal im Entferntesten aus dem Mooreschen Gesetz oder Ähnlichem“, sagte Rosenfeld, der auch Mitbegründer und CTO des KI-Startups im Gesundheitswesen ist. somite.ai.

Diese Entwicklung weist auf eine Zukunft hin, in der Software eine entscheidende Rolle bei der Optimierung über verschiedene Hardwareplattformen hinweg spielt und die Abhängigkeit von einem einzelnen Anbieter reduziert wird. Obwohl Nvidias CUDA auf Einzelchipebene ein leistungsstarkes Tool ist, wird eine Umstellung auf eine softwareabhängige Landschaft, die für sehr große Modelle mit vielen GPUs erforderlich ist, dem Unternehmen nicht unbedingt Vorteile bringen.

„Wir werden wahrscheinlich eine Konsolidierung erleben“, sagte Rosenfeld. „Es gibt viele Neueinsteiger und viel Geld und es ist definitiv viel Optimierungspotenzial vorhanden.“

Rosenfeld sieht keine Zukunft ohne Nvidia als treibende Kraft beim Training von KI-Modellen wie ChatGPT. Durch Training lernen KI-Modelle, Aufgaben auszuführen, während sie dieses Wissen bei der Inferenz nutzen, um Aktionen auszuführen, z. B. um auf Fragen zu antworten, die Benutzer einem Chatbot stellen. Der Rechenleistungsbedarf für diese beiden Schritte ist unterschiedlich, und während Nvidia für den Trainingsteil der Gleichung gut geeignet ist, sind die GPUs des Unternehmens nicht ganz so gut für die Inferenz ausgelegt.

Trotzdem war die Inferenz verantwortlich für schätzungsweise 40 % des Rechenzentrumsumsatzes des Unternehmens im letzten Jahr, sagte Nvidia in seinen neuesten Gewinnbericht.

„Ehrlich gesagt sind sie besser im Training“, sagte Jonathan Ross, CEO und Gründer von Groq, einem KI-Chip-Startup. „Man kann nichts bauen, das in beiden Bereichen besser ist.“

„Für Schulungen gibt man Geld aus, und mit Schlussfolgerungen verdient man eigentlich Geld“, sagt Ross. „Unternehmen können jedoch überrascht sein, wenn ein KI-Modell in Produktion geht und mehr Rechenleistung benötigt als erwartet – und so die Gewinne schmälert.“

Hinzu kommt, dass GPUs, die wichtigsten von Nvidia hergestellten Chips, nicht besonders schnell Antworten für Chatbots ausspucken. Während Entwickler eine kleine Verzögerung oder Verzögerung während eines einmonatigen Trainings nicht bemerken, möchten Menschen, die Chatbots verwenden, möglichst schnelle Antworten.

Ross, der zuvor bei Google an Chips gearbeitet hatte, gründete Groq, um Chips namens Language Processing Units (LPUs) zu bauen, die speziell für Inferenzen entwickelt wurden. Ein Drittanbietertest von Künstliche Analyse hat festgestellt, dass ChatGPT mehr als 13-mal schneller laufen könnte, wenn es die Chips von Groq verwendete.

Ross sieht Nvidia nicht als Konkurrenten, scherzt jedoch, dass Kunden, die bei Groq gekauft haben, in der Warteschlange für Nvidia-Chips oft weiter nach vorne rücken. Er sieht sie eher als Kollegen in diesem Bereich – sie übernehmen die Schulung, während Groq die Schlussfolgerungen zieht. Tatsächlich, so Ross, könne Groq Nvidia dabei helfen, mehr Chips zu verkaufen.

„Je mehr Leute endlich anfangen, mit Inferenz Geld zu verdienen“, sagte er, „desto mehr werden sie für Schulungen ausgeben.“

Dieser Inhalt wurde maschinell aus dem Originalmaterial übersetzt. Aufgrund der Nuancen der automatisierten Übersetzung können geringfügige Unterschiede bestehen. Für die Originalversion klicken Sie hier