Nvidia-CEO Jensen Huang stellte den mit Spannung erwarteten neuen Prozessor des KI-Chipherstellers vor Am Montag hieß es, dass Technologiegiganten wie Microsoft und Google bereits sehnsüchtig auf seine Ankunft warten.

Huang machte die Ankündigung während die vielbeachtete GPU-Technologiekonferenz des Unternehmens, oder AGB, das von als „Woodstock der KI“ bezeichnet wurde Mitarbeiter und Analysten Ebenso. Die Jahreskonferenz in San Jose, Kalifornien, fand unter Federführung von Nvidia statt ein Wall-Street-Rausch nach KI-Aktien bis Start 2024 - übertrifft die himmelhohen Gewinnerwartungen, werden der erste Chiphersteller, der eine Marktkapitalisierung von 2 Billionen US-Dollar erreichte, und an vorbei Unternehmen darunter Amazon zu Werden das drittwertvollste Unternehmen der Welt.

Der Aufstieg von Nvidia wurde durch seine 40.000 US-Dollar teuren H100-Chips vorangetrieben, die die sogenannten großen Sprachmodelle antreiben, die benötigt werden, um generative KI-Chatbots wie ChatGPT von OpenAI zu führen. Die Chips sind als GPUs bekannt oder Grafikverarbeitungseinheiten.

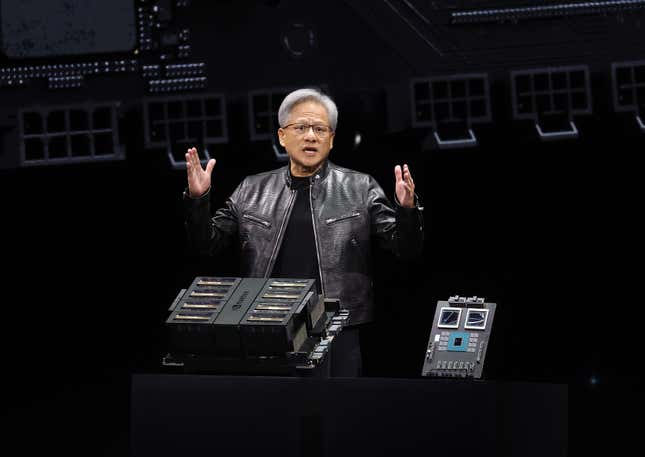

Am Montag stellte Huang Nvidias GPU der nächsten Generation „Blackwell“ vor, benannt nach dem Mathematiker David Blackwell, dem ersten schwarzen Gelehrten, der in die National Academy aufgenommen wurde Der Blackwell-Chip besteht aus 208 Milliarden Transistoren und wird in der Lage sein, KI-Modelle und Abfragen schneller zu verarbeiten als ihre Vorgänger , sagte Huang. Die Blackwell-Chips sind erfolgreich Nvidias äußerst gefragter H100-Chip, die nach der Computerwissenschaftlerin Grace Hopper benannt wurde. Huang nannte Hopper „die fortschrittlichste GPU der Welt, die heute in Produktion ist.“

„Hopper ist fantastisch, aber wir brauchen größere GPUs“, sagte er. „Meine Damen und Herren, ich möchte Ihnen gerne einen vorstellen sehr große GPU.“

Microsoft, Googles übergeordnetes Alphabet und Oracle gehören zu den Technologiegiganten, die sich auf Blackwell vorbereiten, sagte Huang. Microsoft und Google sind zwei von Nvidias Unternehmen größte Kunden für seine H100-Chips.

Die Nvidia-Aktie blieb am Montag weitgehend unverändert, ist aber in diesem Jahr bislang um mehr als 83 % und im Vergleich zu den letzten zwölf Jahren um mehr als 241 % gestiegen Monate.

Lesen Sie mehr: Befindet sich die Nvidia-Aktie in einer Blase, die platzen wird? Wall Street kann sich nicht entscheiden

Während seiner Grundsatzrede auf der Nvidia-Konferenz am Montag kündigte Huang neue Partnerschaften mit den Computersoftwareherstellern Cadence, Ansys und Snyopsys an. Cadence, Huang Huang sagte:

Huang rief im Publikum auch den Gründer und CEO von Dell, Michael Dell, hervor, dessen Unternehmen mit Nvidia zusammenarbeitet Dell erweitert sein KI-Angebot an Kunden, einschließlich neuer Unternehmensdatenspeicherung mit Nvidias KI-Infrastruktur.

„Jedes Unternehmen muss KI-Fabriken bauen“, sagte Huang. „Und es stellt sich heraus, dass Michael hier ist, und er freut sich darüber Nehmen Sie Ihre Bestellung entgegen.

Huang gab außerdem bekannt, dass Nviida mit seinem neuen generativen KI-Modell CorrDiff ein digitales Modell der Erde erstellt, um Wettermuster vorherzusagen die 12,5-mal höher aufgelöste Bilder erzeugen kann als aktuelle Modelle.

Und Huang sagte, dass die Computerplattform Omniverse von Nvidia jetzt darauf streamt Apples Vision Pro Headset, und dass der chinesische Elektrofahrzeughersteller BYD das von Nvidia übernimmt Computer der nächsten GenerationThor.

Huang beendete seine zweistündige Keynote, begleitet von zwei Robotern, den orangefarbenen und grünen Star Wars BD-Droiden, von denen er sagte, dass sie es seien powered by Nvidia Jetson-Computersystemeund mit denen man laufen lernte Nvidias Isaac Sim.

Die ganze Woche über im GTC Nvidia-Forscher und -Führungskräfte werden von wichtigen Akteuren der KI-Branche begleitet - darunter Brad Lightcap, Chief Operating Officer von OpenAI, und Arthur Mensch, Chief Executive des französischen OpenAI-Rivalen Mistral AI -um zu liefern Sitzungen zu Themen von Innovation bis Ethik.

Microsoft und Meta sind Nvidias größte Kunden für seinen H100-ChipBeide Tech-Giganten gaben im Jahr 2023 jeweils 9 Milliarden US-Dollar für Chips aus. Alphabet, Amazon und Oracle waren ebenfalls die Top-Chip-Ausgaben letztes Jahr.

Aber der Hype um die H100-Chips von Nvidia hat zu Sorgen über Engpässe geführt, und Konkurrenten, die im KI-Rennen die Nase vorn haben wollen, haben begonnen, sich zu etablieren eigene Versionen der Chips. Amazon hat an zwei Chips genannt Inferentia und Tranium gearbeitet, während Google an seinem Tensor gearbeitet hat Verarbeitungseinheiten.

Dieser Inhalt wurde maschinell aus dem Originalmaterial übersetzt. Aufgrund der Nuancen der automatisierten Übersetzung können geringfügige Unterschiede bestehen. Für die Originalversion klicken Sie hier